רוצים להכשיר את העובדים שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להישאר מעודכנים? הצטרפו לקבוצת הווצאפ שלנו

רוצים להכשיר את העובדים שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להישאר מעודכנים? הצטרפו לקבוצת הווצאפ שלנו

רוצים להכשיר את העובדים שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להישאר מעודכנים? הצטרפו לקבוצת הווצאפ שלנו

רוצים להכשיר את העובדים שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להטמיע AI בחברה שלכם? בואו נדבר

רוצים להישאר מעודכנים? הצטרפו לקבוצת הווצאפ שלנו

פתיחה

אתם פותחים את המקרר, בוחנים את תאריך התפוגה של החלב ורק אז שופכים לקפה. בדיוק כמו שלא תשתו משהו מבלי לדעת מה מצבו, כך גם לא נרצה להשתמש בכלי בינה מלאכותית בלי להבין לפחות במידה בסיסית איך הוא מקבל החלטות.

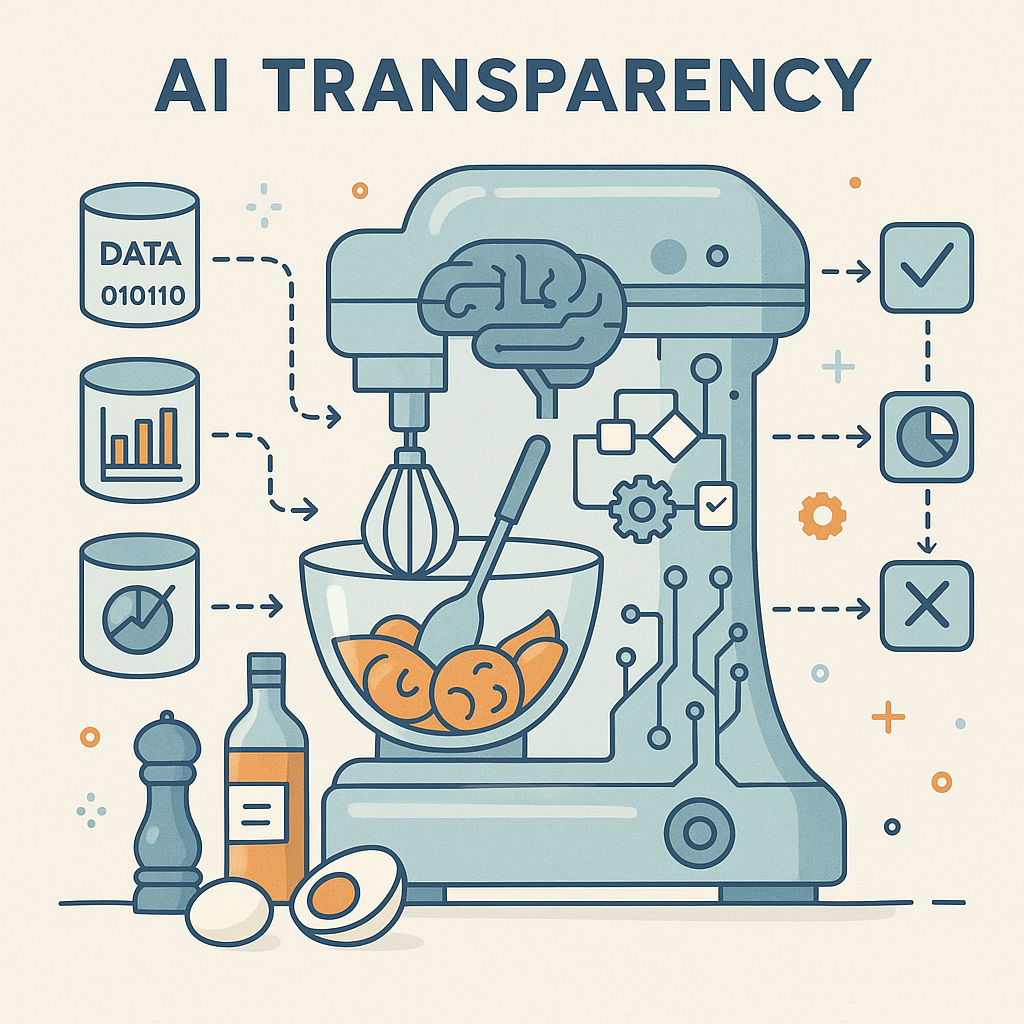

שקיפות: ההגדרה הפשוטה

שקיפות בבינה מלאכותית היא היכולת לראות ולהסביר בצורה ברורה מדוע המודל הגיע לתוצאה מסוימת. במקום קופסה שחורה שמחזירה תשובה סופית, אנחנו מבקשים חלון הצצה לתהליך: אילו נתונים הוזנו, אילו כללים הופעלו ומה היו השלבים בדרך. מטרת השקיפות היא לעזור לנו לבטוח בכלי, לזהות טעויות ולשפר את השימוש בו.

כמו בדיקת רכיבים במטבח

תארו לכם שאתם אופים עוגה חדשה. לפני שמערבבים, אתם קוראים את רשימת המרכיבים, מוודאים שאין אלרגנים ומשווים לכמה מתכונים כדי להבין מי תורם למה. אם בסוף העוגה לא מצליחה, תוכלו לעבור שלב-שלב ולזהות אם היה חסר סוכר או שהטמפרטורה לא התאימה. באותו אופן, שקיפות במודלי AI מאפשרת לנו לבדוק את “מרכיבי” ההחלטה, ולהבין מה השתבש או מה גרם לטעם המוצלח.

למה זה משנה בעבודה שלכם

כשאתם משתמשים בכלי כתיבה אוטומטית, מחולל תמונות או עוזר מחקר, החלטות המודל משפיעות ישירות על המסמך, על המסר ועל המוניטין שלכם. אם אינכם יודעים על מה התבסס, אתם עלולים לצטט עובדה שגויה, לפספס הטיה סמויה או להפר זכויות יוצרים מבלי לשים לב. שקיפות מאפשרת לבדוק את המקורות, להבין אילו שיקולים הופעלו ולהחליט אם לקבל או לדחות את ההצעה.

מעבר לכך, רגולציות חדשות (כמו חוקי AI באירופה) מחייבות אחריות ומשמעת. ארגונים שיכולים להראות תיעוד והסבר לפעולת המודלים שלהם עומדים ביתר קלות בדרישות, בעוד מי שפועל בקופסה שחורה מסתכן בקנסות ובפגיעה באמון הלקוחות. לכן, גם אם אינכם מפתחים, הבנה בסיסית בשקיפות מגינה עליכם מפני סיכונים ומעלה את ערך העבודה שאתם מציעים.

טיפים מהירים לבדיקת שקיפות בכלי AI

1. חפשו אפשרות “הצג מקורות” או “הסבר החלטה” בכל ממשק שאתם משתמשים בו – אם אין כזו, שאלו מדוע. 2. נסו להזין בקשות דומות ולראות אם המודל מסביר מה השתנה בתשובה; עקביות היא סימן טוב לשקיפות. 3. קראו את מדיניות הפרטיות: האם מצוין מאיפה נאספו הנתונים וכיצד הם מאוחסנים? 4. במידת הצורך, בקשו תיעוד מהספק – פירוט כזה זמין לרוב, אך רק למי ששואל.

כשתחושת הבטן אומרת שמשהו לא מסתדר

ניסיתם לבקש מצ’אט-GPT לנסח מייל רשמי וקיבלתם פתאום פסקה מנופחת במילים מיושנות, או שהרצתם ב-Midjourney פרומפט לעיצוב לוגו וגיליתם שהצבעים רחוקים לגמרי מההנחיות. הרגע הזה, שבו אתם מרגישים “זה לא אני ביקשתי”, נובע לרוב מחוסר שקיפות: אין לכם חלון לראות אילו דוגמאות כתיבה או אילו תמונות דומות הופעלו ברקע ולהסביר את ההטיה. התחושה היא כמו לשוחח עם מישהו שמסתיר חצי מהסיפור; אתם חייבים לנחש מה גרם לו לבחור דווקא בניסוח או בגוון המסוים. אם המערכת הייתה חושפת, אפילו ברמה בסיסית, על אילו סגנונות היא נשענת או איזה משקל קיבלו מילות המפתח, קל היה לחתוך במהירות את החלקים הבעייתיים ולחסוך סבבי ניסוי-וטעות.

לדוגמה, משתמשי Claude שמפעילים את מצב “Chain-of-Thought” מקבלים פירוט מקוצר של שלבי ההסקה ופתאום מבינים מדוע המודל בחר לצטט מקור ישן במקום מאמר עדכני. ברגע שההיגיון גלוי, אפשר לרענן את הבקשה ולמנוע את אותו פספוס בפעם הבאה.

זיכרון קצר והטיות נסתרות: מה באמת קורה מתחת למכסה

כשאתם ממשיכים שיחה ארוכה עם בוט ומגלים שהוא “שכח” נתון שהוזכר לפני רגע, זו לא עצלות אלא מגבלה מתודית: המודל מחלק את הטקסט ליחידות עבודה ומקצה משאבים מוגבלים לזיכרון לטווח-רחוק. אם היינו רואים את התרשים הפנימי, היינו מבחינים שהמידע פשוט נדחק על ידי פניות חדשות, ממש כמו פתקים שמצטברים על שולחן עד שהקודם מחליק לרצפה. חוסר שקיפות הופך את הדחיקה הזאת לבלתי נראית, ולכן האשמה נופלת עלינו או על “ה-AI שעשה בעיות”.

הטיה היא סיפור דומה. נניח שביקשתם מדריך תיירותי באירופה וקיבלתם המלצות בעיקר לבירות מערביות; בלי לחשוף אילו מאגרי מידע הזינו את התשובה, קשה לדעת שמדינות קטנות פשוט לא הופיעו לעיני המודל. ברגע שנבין שהמקור היה, למשל, בלוגים פופולריים באנגלית בלבד, קל להשלים חצי העבודה החסרה ולבקש הרחבה ספציפית.

איך הופכים את העיקרון לכלי עבודה ולא רק לסיסמה

השלב הראשון הוא לדרוש מהמודל “לחשוב בקול” – בכל פעם שאתם מנסחים פרומפט, הוסיפו משפט שמבקש הסבר קצר לדרך קבלת ההחלטות. בצ’אט-GPT הצירוף “הצג את שלבי הנימוק בקצרה” יגרום למערכת לפרוש את הקשרים שעשתה; מפתיע לגלות עד כמה צעד זה מצמצם גרסאות לא רלוונטיות ומקצר עריכות.

השלב השני הוא לשלב שאלות עומק על המקורות: “על אילו מאמרים הסתמכת?”, “איזה סגנון עיצובי זיהית כדומיננטי?” שאלות כאלה לא רק משפרות את התוצאה המיידית אלא בונות הרגל בריא של בחינת אמינות, ממש כמו בדיקת תאריך התפוגה שהזכרנו בפתיחה. לאורך זמן תגלו שפחות עבודה נשפכת על תיקונים ויותר מושקעת ביצירתיות.

ולבסוף, אימוץ שקיפות כקריטריון בחירת כלים מייצר אפקט מצטבר: כשנתעדף פלטפורמות שמספקות “חלון הצצה” נשלח לשוק אות ברור – המשתמשים מבקשים אחריות, לא קסם אפל. הספקים שמקשיבים יפתחו יכולות הסבר עשירות יותר, ואנחנו נקבל מחוללים שניתן לסמוך עליהם באמת, לא רק חלב עם עטיפה יפה.